Startup Portfolio

ビデオを瞬時に、インテリジェントに検索し、理解できるようにする基盤モデルを開発する"Twelve Labs"がSeries Aで$50Mを調達

Twelve Labsは、New Enterprise Associates(NEA)とNVentures(NVIDIAのCVC)が共同リードし、Index Ventures、Radical Ventures、WndrCo、Korea Investment Partnersなどが参加したSeries Aで$50Mを調達した。

動画のあらゆる側面に特化した業界をリードする基盤モデルを開発するTwelve Labsは、ビデオを瞬時に、インテリジェントに検索し、理解できるようにします。Twelve Labsの最先端ビデオ理解テクノロジーは、組織の膨大なビデオの海から価値ある瞬間を正確かつタイムリーに発見し、ユーザーがより多くのことを行い、学ぶことを可能にします。

Twelve Labsは、NVIDIA H100 Tensor Core GPUやNVIDIA L40S GPU、NVIDIA Triton Inference ServerやNVIDIA TensorRTなどの推論フレームワークなど、多くのNVIDIAフレームワークやサービスを自社のプラットフォームに統合しています。これらの技術により、同社は、マルチモーダル映像理解のための世界初の基礎モデルを開発することができました。また、同社は、クラス最高のマルチモーダル基礎モデルとそれを可能にするフレームワークを市場に投入するために、NVIDIAとの製品および研究協力を模索しています。

「私たちは、未来はマルチモーダルであると考えており、Twelve Labsは、マルチモーダルAIを効率的で、目的に適い、エンタープライズグレードにする方法を見つけ出すという点で、先導的な役割を果たしています。同社は、AIにおける最も複雑でエキサイティングな問題の1つを解決するために、世界中から信じられないほど才能豊かなチームを集めました。Twelve Labsは、映像理解とマルチモーダルAIの未来を築こうとしており、私たちは、彼らがビジョンを実行し、私たちの世界にポジティブな影響を与えるようサポートできることを嬉しく思います。」とNEAのPartnerは説明します。

「Generative AIのコア・コンポーネントとして、マルチモーダル映像理解は、業界全体でより強固なLLMを提供するための鍵となります。Twelve Labsの世界トップクラスのチームは、NVIDIAのアクセラレーテッド・コンピューティングとビデオ理解の驚異的な能力を活用し、企業顧客がGenerative AIを活用するための新たな方法へとつなげています。」とNVenturesのCorporate VPは説明します。

モダリティを超えた理解は、既存のLLMの機能としてボルトオンで追加できるものではありません。マルチモーダルな基礎モデルは、実際には最初からそうでなければありません。他のアプローチでは、従来のコンピュータ・ビジョンの理解とともにトランスクリプション分析を行い、それらをつなぎ合わせてビデオ理解を試みることで、LLMのパラダイムにビデオ理解を組み込もうとしています。他の基礎モデル提供者とは対照的に、Twelve Labsは特にマルチモーダル映像理解のために設立されました。

同社がリリースしたMarengo-2.6モデルは、最先端のマルチモーダル埋め込みモデルであり、現在一般に提供されているものとは一線を画しています。Marengo 2.6は、マルチモーダルな表現タスクへの先駆的なアプローチを提供します。ビデオだけでなく、画像や音声にも対応し、Text-To-Video、Text-To-Image、Text-To-Audio、Audio-To-Video、Image-To-Videoなど、あらゆる検索タスクを実行します。Marengo-2.6 のユニークなアーキテクチャは、「Gated Modality Experts」 というコンセプトに基づいています。これにより、包括的なマルチモーダル表現に統合する前に、マルチモーダル入力を専用のエンコーダーで処理することができます。このモデルは、映像理解技術における大きな飛躍を意味し、様々なメディアタイプにわたって、より直感的で包括的な検索機能を可能にします。

Twelve Labsはまた、ビデオ言語モデリングの新たな標準となるPegasus-1のベータ版も公開しました。Pegasus-1は、複雑なビデオコンテンツを理解し、明確に表現するように設計されており、マルチメディアの扱い方や分析方法を変革します。Pegasus-1は、ビデオ入力から非常に正確かつ詳細に言語を処理・生成することができます。10月のクローズド・ベータ版リリース以来、改良を重ね、今回のオープン・ベータ版では、より速く、よりアクセスしやすく、パフォーマンスを向上させました。そのためにTwelve Labsチームは、ビデオ・エンコーダー、ビデオ言語アライメント・モデル、言語デコーダーの3つのコンポーネントを共同で学習させ、モデルのサイズを800億パラメータから170億パラメータへと大幅に縮小しました。Twelve Labsは今後数ヶ月のうちに、より大きなモデルをサポートできる組織向けに、さらにフラッグシップのPegasusモデルをリリースする予定です。

最適なパフォーマンスを得るために、これらのモデルはエンベッディングを活用します。しかし、今日のエンベッディングのほとんどは「ユニモーダルテキストエンベッディング」であり、開発者が扱えるデータはテキストベースのみです。このため、Twelve Labsは、既存のVideo Search APIとClassify APIを駆動する生のマルチモーダル埋め込みに直接アクセスできるEmbeddings APIを発表しました。この世界初のAPIは、すべてのデータモダリティ(画像、テキスト、音声、動画)をサポートし、各モダリティのサイロ化されたソリューションに依存することなく、データを同じ空間のベクトルに変換しいます。

この新しいEmbeddings APIは、Twelve Labsのビデオ・ファンデーション・モデルと推論インフラによって提供されます。単一のAPIでマルチモダリティのネイティブサポートを提供することで、Twelve Labsはモデルが理解する必要のある大量のアセットを低レイテンシーで相殺することができます。これらの進歩は、Twelve Labsのミッションである「動画をテキストと同じように簡単にする」ことの達成に向けた重要な一歩です。

「私たちの仕事、特に知覚推論研究を通じて、私たちはマルチモーダルAIに関連する問題を解決しています。私たちは、人間と同じように世界を理解する必要があり、すべての将来のAIエージェントのためのセマンティック・エンコーダーになることを目指しています。Marengo-2.6、Pegasus-1、そして我々のEmbeddings APIは大きな飛躍を意味します。Series Aの資金調達により、私たちはさらなる研究開発に投資し、すべての職務において積極的に雇用することができます。また、ビデオ理解の境界をなくすために、現存する最も革新的で先進的な企業とのパートナーシップを築き続けることができます。」とTwelve Labsの共同創業者兼CEOは説明します。

顧客とパートナーはTwelve Labsの技術に魅了されています。プラットフォームを発表して以来、Twelve Labsは、スポーツ、メディア、エンターテイメント、広告、自動車、セキュリティなどの著名な組織で、セマンティックビデオ検索や要約などのタスクにAPIを活用している3万人のユーザーを抱えています。そうすることで、同社はVidispine、EMAM、Blackbirdなどの企業と深い業界パートナーシップと統合を確立し始めています。

関連ニュース

Twelve Labs に興味がありますか?

最新ニュース

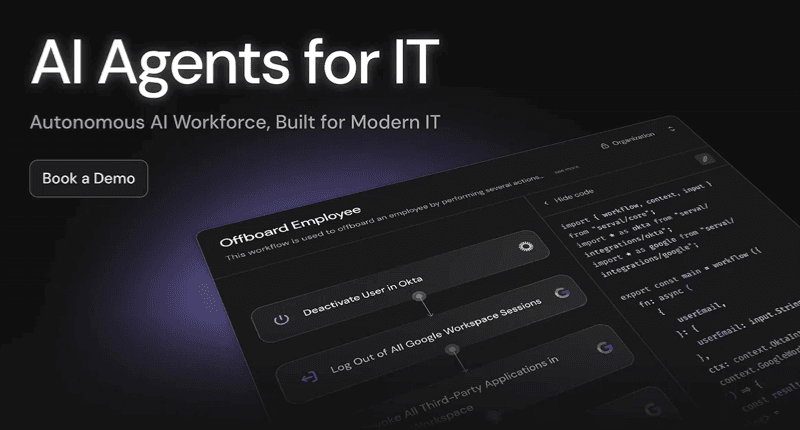

AIを活用し企業向けIT自動化とサービス管理の新時代を築く"Serval"がSeries Bで$75Mを調達し評価額が$1Bに急拡大

2025/12/12

ベルギーに拠点で欧州の輸送事業者の運用コストを削減するTMSを提供する"Qargo"がSeries Bで€28Mを調達

2025/12/12

Humanoid Roboticsの1X、EQTと提携し最大1万台のヒューマノイドをポートフォリオ企業向けに展開へ

2025/12/12

Oncology BiotechのAvenzo Therapeutics、CDK2阻害薬AVZO-021の第1/2相試験の初期データを発表

2025/12/12

大規模AIプロダクト向けの推論基盤のBaseten、ポストトレーニングのParsedを買収し推論から継続学習までを統合

2025/12/12