Startup Portfolio

Big Data AnalyticsのCoralogix モダンな観測可能性を実現するデータディスカバリーの自動化

昔々、中途半端なダッシュボードとログファイル上で実行されるtailコマンドが、観測可能性の最先端でした。快適とは言えませんが、仕事はできました。しかし今、観測可能性は複雑なツール、技術、アーキテクチャの巨大な塊に成長しました。これらはすべて、現代のソフトウェア工学における最大の問題の1つに対応するために生み出されたものです。つまり、このテレメトリーデータを一体どうするのか、ということです。しかし、なぜデータ規模が問題になるのでしょうか?それは、スケールがすべてに影響を与えるからです。クエリのパフォーマンスからコストまで。システムが大規模なデータセットを扱うようになるとすぐに、そうした単純なエンジニアリングの問題はすべて変化し、倍増します。エンジニアとして、もしあなたが独自のELKスタック(Elasticsearch、Logstash、Kibana)を実行しているなら、これはシングルノードクラスタでは無理だということを意味します。フルスタックの観測プラットフォームプロバイダーの顧客であれば、これは典型的な高コストとオーバーエイジを意味します。

優秀なデータサイエンティストなら誰でも、データのゴールドスタンダードとは、素早く照会でき、構造が一貫していて、何時間も待たずに変換できるようなものだと言うでしょう。テレメトリーデータは、このゴールドスタンダード以上のものを必要とします。なぜなら、状況が悲惨である可能性があるため、情報を即座に入手する必要があるからです。2分程度のクエリであれば、1回実行すれば問題ありませんが、Luceneクエリを書いたことがある人なら、調査を成功させるためには20~30回程度のクエリが必要であることを知っているでしょう。これは60分の待ち時間です。

それでは、スムーズな、そして本質的に自動化されたデータディスカバリーに必要なものは何でしょうか。データディスカバリーはインタラクティブなプロセスで、エンジニアは長い待ち時間なしにデータを照会することができます。エンジニアは、データを変換して検査し、フィールドを集約してトレンドを検出する、といった具合です。このようなことを行うには、主に自動化によって駆動されるいくつかの重要な機能が必要です。

高速クエリ : データ量が飛躍的に増加する中、ユーザーは最大でも数秒で完了するクエリを必要としています。遅いクエリにかかるコストは、もはや経済的ではありません。

IDEスタイルのエクスペリエンス : ソフトウェアエンジニアは、IDEで常にデータ構造を探求しており、IDEはすべてのフィールド、関数、メソッド、変数にインデックスを付けることができます。複雑なデータ階層のすべてのフィールドを記憶することは不可能であるため、Observabilityプロバイダーはこの機能を必要としています。

高価なストレージに依存しない : 簡単なアクセスと高価なストレージは切り離す必要があります。ペタバイトのデータを高価なストレージに保存する余裕は企業にはなく、このコスト障壁が採用の大きな阻害要因となっています。

ユーザーにデータ発見のための最高の体験を提供する企業は、市場で大きな優位に立つことができます。そのためには、膨大な量のデータへのアクセスを維持する費用対効果の高い方法を見つけ、データ発見のための洗練されたユーザー体験を作り、他の誰にもできないパフォーマンスの最適化を行う必要があります。データ量が増加するにつれ、ベンダーがこれらの重要なポイントを実現することへのプレッシャーはますます大きくなっていくでしょう。

関連ニュース

Coralogix に興味がありますか?

最新ニュース

顧客価値を高めるロイヤルティ体験を提供する金融プラットフォームの"Imprint"がSeries Dで評価額$1.2Bで$150Mを調達

2025/12/19

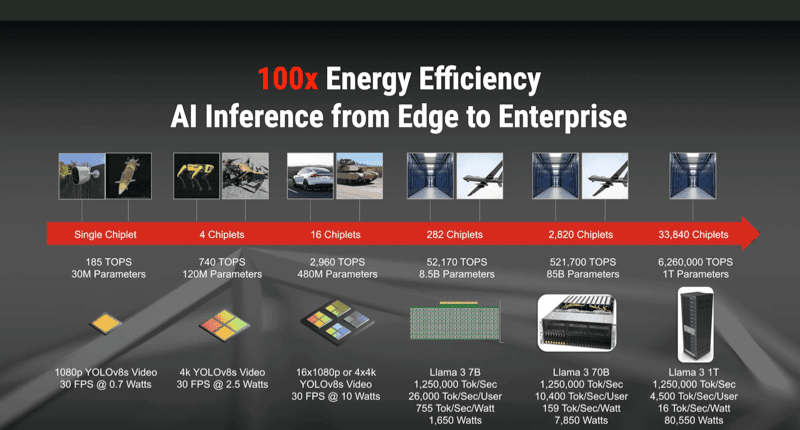

AIが抱える電力問題を解決するアナログAIチップを開発する"Mythic"がSeries Dで$125Mを調達

2025/12/19

Enterprise AI OpsのImpala AI、AIワークロードの統合運用レイヤーで本番展開の効率化を狙い正式ローンチ

2025/12/19

建設業の給与、現場オペレーションのMiter、2025 SuiteCloud Breakthrough Partner of the Yearに選出

2025/12/19

Lifecycle MarketingのEikona、強化学習でA/Bテストとコンテンツ最適化を自動化するGenAI基盤にシード500万ドルを調達

2025/12/19