Startup Portfolio

AI21 LabsのAI新モデルは大量のコンテキストを処理可能

AI業界では、ますます長いコンテキストを扱える生成AIモデルに移行しつつあります。しかし、大きなコンテキストウィンドウを持つモデルは計算リソースを多く必要とする傾向にあります。AIスタートアップAI21 Labsのプロダクトリードであるオー・ダガンは、そうである必要はないと主張し、その主張を裏付けるために同社は新しい生成AIモデルをリリースしました。コンテキストやコンテキストウィンドウとは、モデルが出力(テキスト)を生成する前に考慮する入力データ(テキストなど)のことです。小さなコンテキストウィンドウのモデルは、最近のやり取りの内容さえ忘れがちですが、大きなコンテキストウィンドウのモデルはこの欠点を回避でき、加えて入力データの流れをよりよく把握できます。

AI21 Labsの新しいテキスト生成・分析モデル「Jamba」は、OpenAIのChatGPTやGoogleのGeminiなどのモデルと同様の多くのタスクを実行できます。公開済みのデータと独自のデータを組み合わせて学習された Jamba は、英語、フランス語、スペイン語、ポルトガル語でテキストを生成できます。

Jamba は、80GB以上のメモリを搭載した単一のGPU(高性能のNvidia A100など)上で動作する場合、最大で14万トークン(約10万5000語、210ページ相当のコンテキスト)を扱うことができます。これに対し、MetaのLlama 2は、現在の基準では小さい方の3万2000トークンのコンテキストウィンドウですが、わずか12GBのGPUメモリで動作します。(コンテキストウィンドウは通常トークンという単位で測られます)。一見すると、Jamba は目新しいものではありません。無料でダウンロードできる生成AIモデルは、DatabricksのDBRXやLlama 2など多数存在します。しかし、Jambaの独自性は内部の仕組みにあります。トランスフォーマーとステートスペースモデル(SSM)の2つのモデルアーキテクチャを組み合わせて使っているのが特徴です。

関連ニュース

AI21 Labs に興味がありますか?

最新ニュース

顧客価値を高めるロイヤルティ体験を提供する金融プラットフォームの"Imprint"がSeries Dで評価額$1.2Bで$150Mを調達

2025/12/19

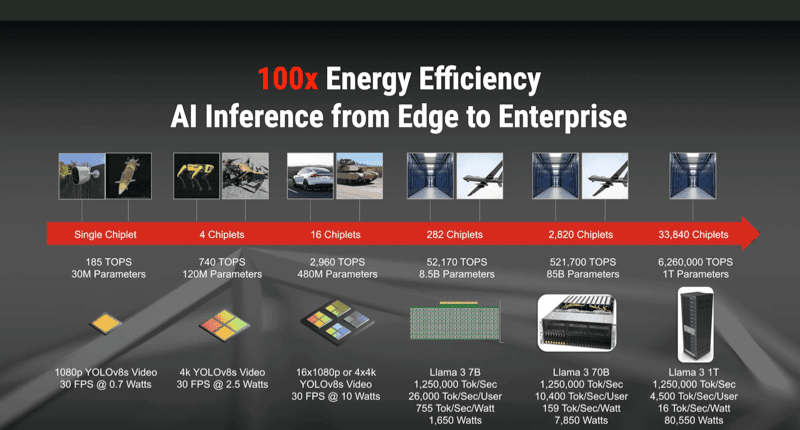

AIが抱える電力問題を解決するアナログAIチップを開発する"Mythic"がSeries Dで$125Mを調達

2025/12/19

Enterprise AI OpsのImpala AI、AIワークロードの統合運用レイヤーで本番展開の効率化を狙い正式ローンチ

2025/12/19

建設業の給与、現場オペレーションのMiter、2025 SuiteCloud Breakthrough Partner of the Yearに選出

2025/12/19

Lifecycle MarketingのEikona、強化学習でA/Bテストとコンテンツ最適化を自動化するGenAI基盤にシード500万ドルを調達

2025/12/19