Startup Portfolio

次世代オープンソースLLMのSarvam、24億パラメータの「Sarvam-M」を発表

インドのAIスタートアップSarvamは、自社開発した大規模言語モデル(LLM)「Sarvam-M」を正式に発表しました。Sarvam-Mは、Mistral Smallをベースに構築された24億パラメータを持つオープンウェイトのハイブリッド型LLMで、数学やプログラミングをはじめ、インド固有の言語理解においても優れた性能を発揮するとしています。幅広い用途に対応する汎用性が設計の特徴です。

Sarvam-Mの主な用途としては、対話型AIや機械翻訳、教育ツールなどが挙げられます。また、高度な数学的推論やプログラミング関連のタスクにも対応可能です。同社によると、このモデルの性能向上には、「教師ありファインチューニング(SFT)」、「検証可能な報酬を用いた強化学習(RLVR)」、「推論最適化」の3段階のプロセスが採用されています。

SFTでは、Sarvamの開発チームが質と難易度を重視して多様なプロンプトを用意し、それをもとに許可されたモデルで生成した出力をカスタムスコアリングで精査しました。さらにバイアス軽減と文化的適合性を調整し、「複雑な推論(thinkモード)」と「一般的な会話(non-thinkモード)」の両方に対応できるよう訓練しています。

RLVRにおいては、指示応答能力やプログラミング、数学タスクを含むカリキュラムを使い、カスタム報酬エンジニアリングやプロンプトサンプリング戦略を通じて、さらなる性能向上を図っています。推論最適化ではFP8精度での量子化を施すことにより、精度をほぼ損なうことなく効率化を達成しました。また、ルックアヘッドデコーディング技術を導入しスループットを向上させましたが、多重並行処理における課題が残されているとのことです。

特にインド言語と数学を組み合わせた「GSM-8K」のようなタスクでは、同モデルが従来モデルに比べ86%以上の改善を示しています。Sarvam-Mは多くのベンチマークテストでLlama-4 Scoutを凌駕しており、規模が大きいLlama-3.3 70BやGemma 3 27Bモデルに匹敵する性能を示しています。一方、英語知識のベンチマーク(MMLU)に関しては、わずかに1%ほど性能低下が見られました。現在、Sarvam-Mは同社のAPIを通じて利用可能で、Hugging Face上からダウンロードして試験や統合が可能となっています。

Sarvamについて

Sarvamはインドを拠点とするAIスタートアップであり、オープンソースの大規模言語モデルの開発を行っています。インドを含む多言語環境に強みを持ち、高度な推論能力を兼ね備えた言語モデルを提供しています。

関連ニュース

Sarvam AI に興味がありますか?

最新ニュース

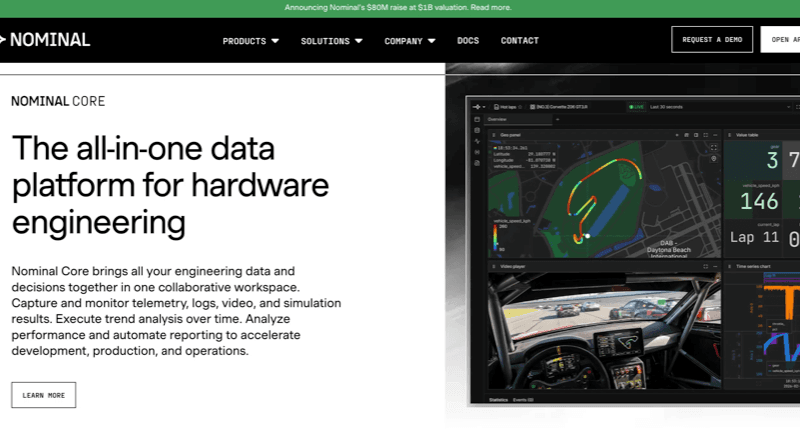

エンジニアのハードウェアテストを大幅に高速化する"Nominal"がSeries B-2で評価額$1Bで$80Mを調達

2026/03/06

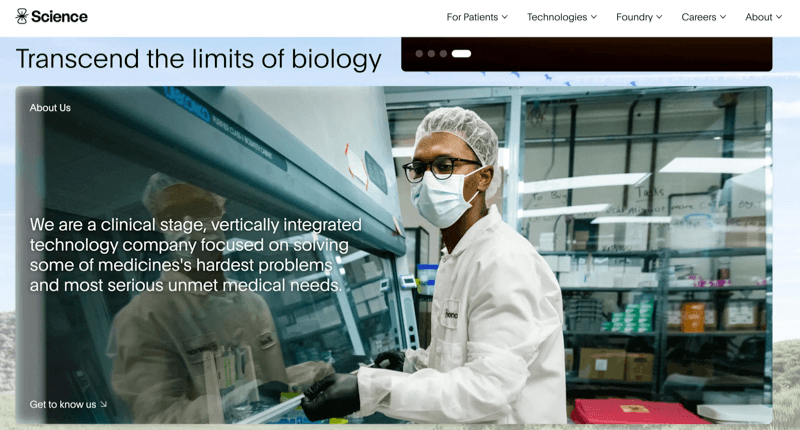

脳の電気信号を直接読み取りコンピュータや機械を操作するBCI技術を開発する"Science"がSeries Cで$230Mを調達

2026/03/06

AI時代に向けて構築されたオープンソースFeatureOpsプラットフォームの"Unleash"がSeries Bで$35Mを調達

2026/03/06

AIネイティブ企業の開発基盤を提供するAIクラウドインフラのTogether AI、初のAI Native Conf開催と研究・製品アップデートを発表

2026/03/06

体内免疫細胞を直接再プログラムする遺伝子治療のLiberate Bio、CAR-M設計特許ライセンス取得

2026/03/06